W niniejszym artykule przedstawione zostaną elementy szyfrowania (kryptografia) i rozpracowywania szyfrów (kryproanaliza).

W praktyce w bezpieczeństwie IT obserwujemy nieustanny wyścig zbrojeń; z jednej strony twórcy systemów, z drugiej ci, którzy próbują je złamać. W samym sercu tej walki leży kryptografia, czyli nauka o utajnianiu informacji. Jej celem nie jest uniemożliwienie przechwycenia danych, lecz sprawienie, by przechwycone dane były dla intruza całkowicie bezużyteczne, stanowiąc jedynie niezrozumiały ciąg znaków. Potrzeba ta jest stara jak sama cywilizacja, gdyż od zawsze istniała potrzeba przekazywania poufnych rozkazów wojskowych, informacji dyplomatycznych czy tajemnic handlowych. Współcześnie, w erze społeczeństwa informacyjnego, gdzie dane stały się najcenniejszą walutą, rola kryptografii wykroczyła daleko poza zastosowania militarne, stając się podstawą naszego cyfrowego życia, chroniąc finanse, prywatność i tożsamość.

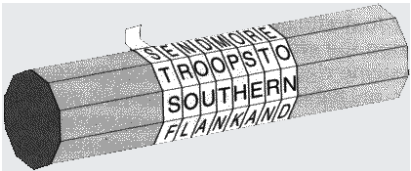

Pierwsze udokumentowane próby zabezpieczania komunikacji sięgają starożytności, gdzie metody te były niezwykle proste i opierały się na zasadzie „bezpieczeństwa przez zaciemnienie” (security through obscurity). Jednym z najwcześniejszych przykładów jest prawdopodobnie spartańska skytale, laska o określonej średnicy, na którą nawijano pas pergaminu; dopiero po nawinięciu go na identyczny atrybut, pozornie bezładne litery układały się w logiczną wiadomość.

Juliusz Cezar z kolei, jak donosi Swetoniusz, stosował prosty szyfr podstawieniowy, znany dziś jako Szyfr Cezara, polegający na przesunięciu każdej litery alfabetu o stałą liczbę pozycji. Choć z dzisiejszej perspektywy metody te wydają się trywialne i możliwe do złamania w kilka sekund, stanowiły one przełom koncepcyjny: oddzieliły treść wiadomości (tekst jawny) od jej formy (szyfrogram), wprowadzając pojęcie algorytmu i – w przypadku skytale – prymitywnego klucza (średnicy laski). Ciekawy artykuł znajdziesz tutaj.

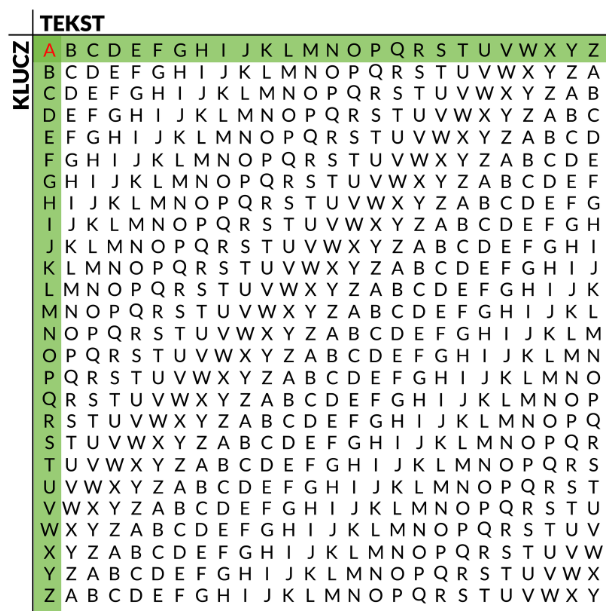

Rozwój kryptografii przez wieki był nierozerwalnie związany z postępem w matematyce i lingwistyce, co doprowadziło do powstania metod znacznie bardziej wyrafinowanych niż proste podstawienie. W średniowieczu i renesansie, szczególnie w państwach włoskich, narodziła się kryptoanaliza – sztuka łamania szyfrów. W odpowiedzi na proste analizy częstotliwości występowania liter, które bezlitośnie obnażały słabość Szyfru Cezara, opracowano szyfry polialfabetyczne. Najsłynniejszym z nich jest Szyfr Vigenère’a, niesłusznie przez wieki nazywany „le chiffre indéchiffrable” (szyfr niemożliwy do złamania). Używał on wielu alfabetów szyfrujących, wybieranych na podstawie słowa-klucza, co skutecznie maskowało naturalne statystyki języka. Przez ponad trzysta lat stanowił on barierę nie do przejścia dla większości analityków, a jego złamanie w XIX wieku przez Charlesa Babbage’a i niezależnie przez Friedricha Kasiski’ego, wymagało już zaawansowanego aparatu analitycznego.

Prawdziwa rewolucja w kryptografii nadeszła wraz z erą mechanizacji i elektryczności na przełomie XIX i XX wieku. Potrzeba szybkiego i bezpiecznego przesyłania informacji za pomocą telegrafu wymusiła odejście od ręcznych metod „papier i ołówek”. Zaczęto konstruować maszyny szyfrujące, takie jak tarcza Wheatstone’a czy późniejsze, bardziej skomplikowane urządzenia wirnikowe. Te mechaniczne cuda pozwalały na realizację niezwykle złożonych przekształceń polialfabetycznych na niespotykaną dotąd skalę. Pionierzy tacy jak Edward Hebern czy Arthur Scherbius, twórca Enigmy, wierzyli, że stworzyli systemy zapewniające absolutne bezpieczeństwo. Ta wiara w technologiczną nieomylność okazała się jednak zgubna, co miało dramatyczne konsekwencje w nadchodzącym konflikcie globalnym.

Druga Wojna Światowa stała się katalizatorem, który przekształcił kryptografię z niszowej dziedziny w kluczowy element wysiłku wojennego i nauki ścisłej. Niemiecka maszyna wirnikowa Enigma oraz bardziej złożona Maszyna Lorenza (Tunny) stały się celem numer jeden alianckich kryptoanalityków. Prace polskich matematyków z Biura Szyfrów – Mariana Rejewskiego, Jerzego Różyckiego i Henryka Zygalskiego – którzy jako pierwsi złamali wojskową Enigmę jeszcze przed wojną, położyły fundamenty pod operacje w Bletchley Park. Tam, zespół pod wodzą Alana Turinga, wykorzystując polskie metody oraz rozwijając własne, skonstruował maszyny (tzw. „bomby kryptologiczne”) zdolne do systematycznego łamania codziennych kluczy Enigmy. Równolegle, prace nad złamaniem Maszyny Lorenza doprowadziły do powstania Colossusa – pierwszego na świecie programowalnego, elektronicznego komputera cyfrowego. To właśnie wtedy, w ogniu walki, narodziły się podwaliny współczesnej informatyki i teorii informacji.

Po zakończeniu wojny, kryptografia w dużej mierze zniknęła z widoku publicznego, stając się domeną agencji wywiadowczych i wojska. Kluczowym momentem dla naukowego ugruntowania tej dziedziny była publikacja pracy Claude’a Shannona z 1949 roku, „Communication Theory of Secrecy Systems”. Shannon, ojciec teorii informacji, jako pierwszy zastosował rygorystyczny aparat matematyczny do analizy szyfrów. Zdefiniował on pojęcie „bezpieczeństwa doskonałego” (perfect secrecy), demonstrując, że osiąga je jedynie szyfr z kluczem jednorazowym (One-Time Pad), który jest jednak skrajnie niepraktyczny w użyciu. Co ważniejsze, Shannon wprowadził koncepcje dyfuzji i konfuzji jako fundamentalnych zasad projektowania silnych szyfrów, które miały na celu jak najskuteczniejsze ukrycie statystycznych zależności między tekstem jawnym, szyfrogramem a kluczem.

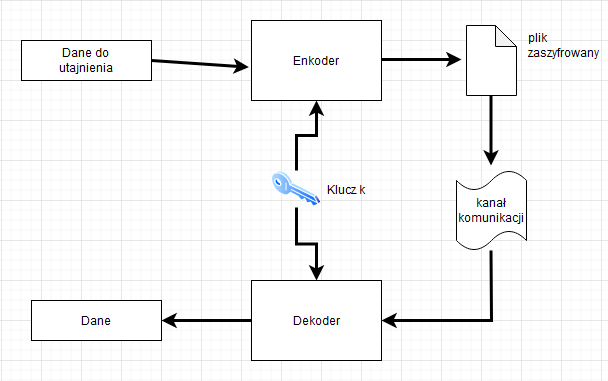

Przełom lat 70. XX wieku otworzył kryptografię dla sektora cywilnego i akademickiego. W 1975 roku IBM, przy udziale Narodowej Agencji Bezpieczeństwa (NSA), opublikował algorytm DES (Data Encryption Standard). Mimo kontrowersji dotyczących krótkiego, 56-bitowego klucza (co zdaniem wielu było celowym osłabieniem), DES stał się pierwszym globalnym standardem szyfrowania. Jego wprowadzenie stymulowało ogromne zainteresowanie badawcze nad projektowaniem i analizą szyfrów blokowych. Doprowadziło to do rozwoju takich metod kryptoanalizy jak kryptoanaliza różnicowa i liniowa, które ostatecznie wykazały słabości DES, ale jednocześnie wzbogaciły warsztat projektantów bezpieczniejszych algorytmów, co zaowocowało później powstaniem standardu AES.

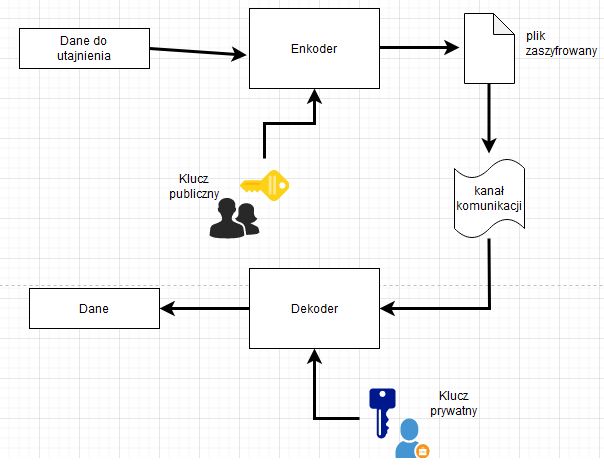

Jednak największa rewolucja koncepcyjna od czasów Szyfru Cezara nadeszła w roku 1976. Whitfield Diffie i Martin Hellman opublikowali artykuł „New Directions in Cryptography”, który rozwiązywał odwieczny problem kryptografii symetrycznej: problem bezpiecznej dystrybucji klucza. Zaproponowali oni radykalnie nowe podejście: kryptografię klucza publicznego, zwaną też asymetryczną. Idea polegała na użyciu dwóch matematycznie powiązanych kluczy – jednego publicznego, który mógł być swobodnie dystrybuowany i służył do szyfrowania, oraz drugiego, prywatnego, trzymanego w ścisłej tajemnicy i służącego do deszyfrowania. Chwilę później, w 1977 roku, Rivest, Shamir i Adleman (RSA) przedstawili pierwszą praktyczną implementację tego pomysłu, opartą na trudności faktoryzacji dużych liczb pierwszych.

Narodziny kryptografii asymetrycznej stały się kamieniem węgielnym współczesnego internetu i e-commerce. To właśnie protokoły oparte na tej idei, takie jak SSL (Secure Sockets Layer), a obecnie TLS (Transport Layer Security), tworzą ową „kłódkę” widoczną w przeglądarce internetowej. Umożliwiają one bezpieczne logowanie do banku, przesyłanie danych karty kredytowej czy poufną korespondencję e-mail (np. przy użyciu PGP/GPG). Kryptografia asymetryczna nie tylko rozwiązała problem wymiany kluczy, ale także dała światu drugie potężne narzędzie: podpisy cyfrowe. Umożliwiają one uwierzytelnienie pochodzenia dokumentu i gwarantują jego integralność, co jest absolutnie kluczowe dla zaufania w cyfrowym świecie.

Dziś stoimy u progu kolejnej rewolucji. Wszechobecne urządzenia IoT (Internet Rzeczy), przetwarzanie w chmurze (Cloud Computing) oraz stale rosnąca moc obliczeniowa generują nowe, bezprecedensowe wyzwania dla bezpieczeństwa. Jednocześnie na horyzoncie majaczy zagrożenie ze strony komputerów kwantowych, które, jeśli staną się rzeczywistością, dzięki algorytmowi Shora będą w stanie w mgnieniu oka złamać większość obecnie stosowanej kryptografii asymetrycznej (jak RSA czy ECC). Dlatego już teraz trwają intensywne prace nad kryptografią postkwantową (PQC), która ma być odporna na ataki kwantowe. Historia kryptografii uczy nas jednego: to niekończąca się ewolucja, a potrzeba ochrony informacji będzie nam towarzyszyć tak długo, jak długo będziemy się komunikować.